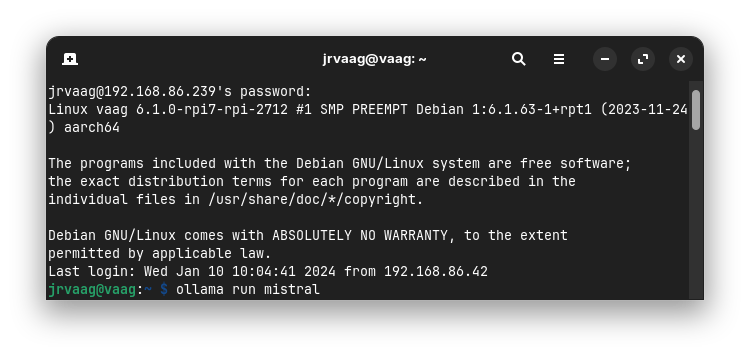

Ja, eller helt hjemmekokt blir det ikke da. Det er basert på halvfabrikata. Men på den lyse siden gjør dette det ganske enkelt å kjøre sin egen lille språkmodell lokalt på egen PC. Selv driver jeg og tester ut dette på en Rasperry Pi 5 som ikke er koblet til internett, men som kan spørres gjennom sikker tilkobling gjennom intranettet. På denne kan jeg kjøre ulike språkmodeller takket være noe som heter Ollama.

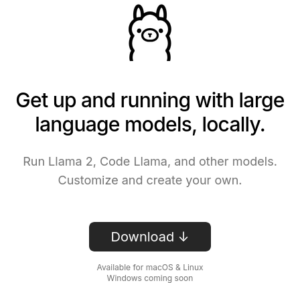

Ollama er et program som muliggjør å laste ned ulike språkmodeller for å kjøre de lokalt på egen datamaskin. Du trenger altså ikke å være så sær at du går til innkjøp av en Rasperry Pi for å leke deg med dette. Fremgangsmåten er også veldig enkel:

- Gå inn på siden til Ollama-prosjektet: https://ollama.ai

- Trykk «Download».

3. Velg operativsystem (per dags dato er dette bare tilgjengelig for Linux og macOS).

Selv synes jeg Mistral har fungert best inntil videre. Har du lyst til å prøve den selv, så skriver du «ollama run mistral» i et terminalvindu for å prøve.

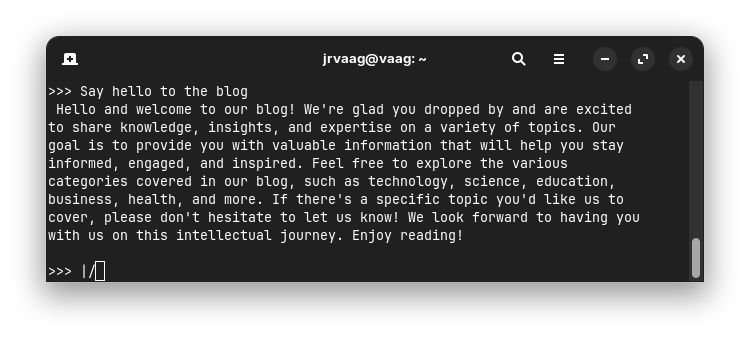

Så snart språkmodellen er lastet ned og mistral er startet opp, så kan du stille de mest utfordrende spørsmål og få de mest intelligente svar.